以编程方式设置和运行 Azure Prompt Flow

在人工智能工程实践中,Azure AI 工程师助理的核心组件——提示流程(Prompt Flow)通过智能化编排大语言模型(LLM)的交互范式,成为提升模型工程化能力的关键工具。该技术不仅实现了提示工程的自动化管道构建,更通过深度集成Azure技术生态,为开发者提供了全生命周期的企业级解决方案。

本技术指南将系统化解析以下核心能力:

开发环境工程化:基于GitHub Codespaces构建标准化开发沙箱,集成密钥轮换与RBAC权限管理体系

可视化流程编排:运用VS Code的Azure Prompt Flow扩展实现拓扑化流程设计,支持版本控制与参数热配置

工程驱动优化:通过Python SDK实现流程的代码化管控,结合批处理引擎与A/B测试框架进行多维度调优

功能扩展机制:利用Python自定义节点实现业务逻辑注入,支持第三方API接入与领域知识增强

生产级验证方案:构建端到端调试链,集成性能探针与容错熔断机制,建立质量门禁标准

云原生部署架构:设计基于Azure Kubernetes Service的弹性部署方案,实现与Key Vault密钥管理、Functions无服务器架构、Logic Apps工作流引擎的深度编排

本指南凝聚Azure AI工程最佳实践,无论是需快速构建PoC验证的技术决策者,还是追求生产环境高可用架构的资深工程师,都将获得从概念验证到规模化落地的全链路赋能方案。

准备开发环境

为保证环境一致性和可重复性,建议使用 GitHub Codespaces或本地 VS Code + Dev Container 的方式来进行开发。以下以 Codespaces 为例,说明环境搭建的步骤。

2.1 设置 GitHub Codespaces

- 创建私有的 GitHub 存储库 :推荐私有以便存放安全配置信息。

- 在 Codespaces 中打开该存储库 :

○ 点击 “Code” 按钮后,选择 “Codespaces” 选项。

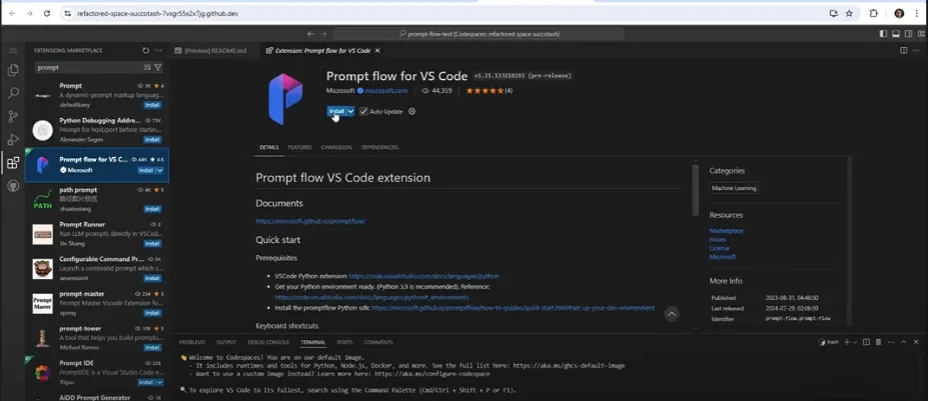

○ 点击 “Create codespace on main” (或“创建新的代码空间”),如果有 Python 基础环境可直接使用。 - 启动 Codespaces 后,在 VS Code 左侧 “Extensions” 中搜索并安装 “Azure Prompt Flow” 扩展程序(名称可能随版本不同,请以官方发布为准)。

提示: 若使用本地 VS Code,需在 .devcontainer 目录添加配置文件,并在容器启动后安装相关依赖。详情可参考 VS Code Remote - Containers 官方文档。

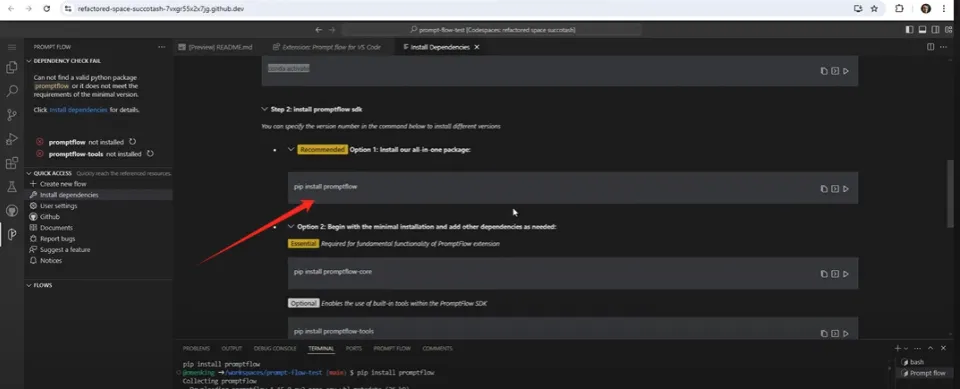

安装依赖

在 Codespaces 终端或本地容器的终端中,先确保已升级 pip :

pip install –upgrade pip

然后根据官方文档或实际需求安装对应的 Prompt Flow 相关包。示例:

以下包名仅作示例,实际包名或版本请以官方发布为准

pip install azure-promptflow promptflow-core promptflow-tools

此外,建议使用更安全的方式来管理 Azure OpenAI API 密钥。例如,在开发环境中可使用 keyring ,在生产环境中则可使用 Azure Key Vault 。这里演示 keyring 的安装:

pip install keyring keyrings.alt

注意:

- 不同版本的 Prompt Flow 包的名称和依赖关系可能会有差异,请确认与您的 Azure 订阅和 VS Code 扩展版本兼容。

- 生产环境或团队协同时,更推荐使用 Key Vault 或 Codespaces Secrets等集中管理方式,而非把密钥明文写在代码或配置文件中。

版本与依赖项说明

为避免版本冲突,可在项目根目录下创建 requirements.txt 并写入类似以下内容:

azure-promptflow==X.X.X

promptflow-core==X.X.X

promptflow-tools==X.X.X

keyring==23.13.1

keyrings.alt==4.2.0

然后在 Codespaces 终端运行:

pip install -r requirements.txt

创建和管理 Prompt Flow

创建新的 Prompt Flow

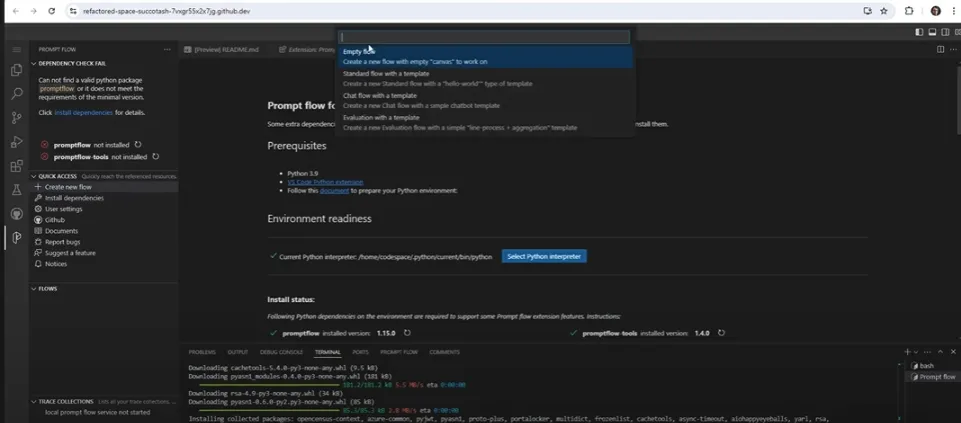

- 在 VS Code 左侧的 “Prompt Flow” 或 “Flow Explorer” 面板,点击 “创建新流程” 。

- 选择 “聊天流程模板(Chat Flow)” ,并将流程命名为 “Easy Math” 。

- 这将自动生成一个基础的提示流程结构,包括输入节点、LLM 节点、输出节点等,用户可在此基础上进行自定义。

配置 Azure OpenAI 连接

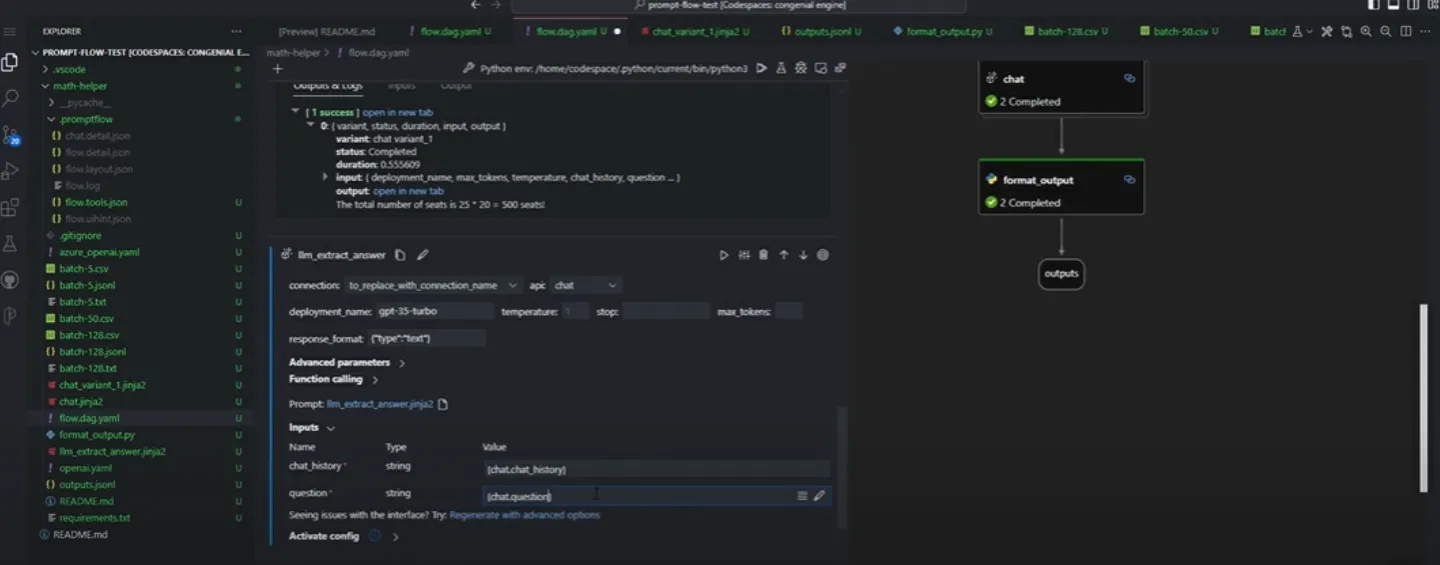

在流程编辑器(可能称为 “Visual Editor” 或 “Flow DAG” )中:

- 点击 “添加连接” ,选择 “Azure OpenAI” 。

- 输入 Azure OpenAI 终结点 和 API 密钥 。如使用本地 Keyring,可在 Python 代码中先写入:

import keyring

keyring.set_password(“AzureOpenAI”, “API_KEY”, “your-api-key”)

然后在扩展界面中选择从 Keyring 中获取或手动填入。

- 点击 “创建连接” ,完成后即可在 VS Code 的流程编辑器中使用已配置的 Azure OpenAI 模型。

提示: 生产环境建议将密钥放在 Azure Key Vault 或 GitHub Codespaces Secrets 中,通过环境变量读取,例如:

import os

endpoint = os.getenv(“AZURE_OPENAI_ENDPOINT”)

api_key = os.getenv(“AZURE_OPENAI_KEY”)

并在 Prompt Flow 配置中引用相应的环境变量。

以编程方式优化提示流程

创建 Python 节点处理提示输出

在流程画布上可添加 Python 节点 ,实现自定义业务逻辑或数据处理。示例:提取数值答案。

def extract_answer(chat_output):

“””从模型输出中提取最终数值答案”””

final_answer = ‘’.join(filter(str.isdigit, chat_output))

return final_answer

然后将上游 LLM 或 “格式化输出” 节点的结果连接到 “提取答案” 节点,这样即可在流程执行时自动运行 Python 代码进行后处理。

批量运行 Prompt Flow

Prompt Flow 支持一次性对多个输入进行批量处理,提高效率。操作步骤大致如下:

- 在流程编辑器或 VS Code 中找到 “批量运行” 选项。

- 选择 “本地文件” 、 “CSV/JSON 文件” 作为输入源。

- 在项目目录放置一个包含多个数学问题的 JSON 或 CSV 文件,例如 questions.json :

[

{“question”: “2 + 2 = ?”},

{“question”: “10 x 5 = ?”},

{“question”: “123 - 45 = ?”}

]

提交运行后,Prompt Flow 会根据文件中的每条记录分别调用 LLM,并输出对应结果至控制台或结果文件中。

注意: 大批量调用可能触发 Azure OpenAI 的配额或速率限制。请根据订阅级别和并发策略进行调优,也可在 Azure Portal 中配置速率限制(Rate Limit)。

高级提示优化与变体测试

变体测试与 Prompt 工程

Prompt Flow 提供 Prompt 变体管理器 或类似功能(具体名称视扩展版本而定),可在同一流程中对比多个 Prompt 文件对结果准确性、格式一致性等指标的影响。示例:

Prompt 文件 variant_a.jinja2

You are a math tutor.

Only provide the final numerical answer.

Prompt 文件 variant_b.jinja2

AI Math Assistant:

Output only the final numerical answer, and no additional text.

然后在 Prompt Flow 变体管理器 中加载 variant_a 与 variant_b ,分别运行批量测试,查看结果差异。从而筛选出对最终准确率最高、输出最符合需求的 Prompt。

连接多个 LLM 提高准确性

在一些高要求场景中,可在流程中连接多个 LLM 节点:

- 第一个 LLM 节点处理问题的核心逻辑。

- 第二个 LLM 节点对结果进行规范化或提取。

如 “LLM 提取答案” 节点可以将原始回答转换成更符合业务需求的格式,减少出错或含糊不清的回答。

提示工程实践与性能监控

● 提示工程 :

○ 尝试多种上下文:如“你是一名数学专家”“你是一名小学老师”等,观察对回答风格与准确性的影响。

○ 使用 Chain of Thought(CoT) 或简化思路,比较只输出最终结果 vs. 同时输出思路要点的效果。

● 性能监控 :

○ 对大规模输入进行测试时,建议结合 Azure Monitor 或 Application Insights ,跟踪接口调用的延迟、错误率和吞吐量。

○ 可以在 Python 节点中使用 logging 模块打印关键日志,或通过 Prompt Flow 自带的日志系统查看执行细节。

生产环境部署与集成

在完成本地或 Codespaces 环境的开发与调试后,通常需要将 Prompt Flow 集成到生产应用或工作流中。以下是一些常见场景的做法:

生产环境中的安全与密钥管理

● Azure Key Vault :在 Azure 中,最常见的做法是使用 Key Vault 来存储并检索机密。开发者可在 Prompt Flow 或 Python 节点中通过 Key Vault SDK 或环境变量来读取密钥,而无需将其暴露在配置文件里。

● GitHub Codespaces Secrets :若仍在 Codespaces 环境中,也可使用仓库或组织级别的 Secrets,在容器中以环境变量形式读取。

与 Azure Functions / Logic Apps 等集成

● Azure Functions :将 Prompt Flow 的调用逻辑封装为一个 Python Azure Function。用户通过 HTTP 触发器调用函数,函数内部运行 Prompt Flow 并返回结果。

● Logic Apps :如果需要构建自动化工作流,可在 Logic Apps 中配置一个动作来调用 Prompt Flow(通过 REST API 或其他集成方式),实现更复杂的企业集成场景,例如当新文本文件上传到 Blob 存储时,自动触发 Prompt Flow 分析。

在 VS Code 中调试与测试 Prompt Flow

运行与调试 Prompt Flow

● 标准模式 :在 VS Code 的 Prompt Flow 面板中,直接输入文本或上传文件进行测试。

● 交互模式 :可能称为“调试模式”或“交互式模式”,允许实时观察节点的输入与输出。

● Python 节点断点调试 :

○ 在 Python 节点对应的脚本中插入断点并使用 debugpy 或 VS Code 自带的调试功能;

○ 在运行 Flow 时即可在 Python 代码执行到断点时查看变量值。

性能监控

● 日志查看 :在本地或 Codespaces 中,可直接查看提示流程执行日志,了解调用时长、模型返回等信息。

● Application Insights :如果已将日志发送到 Azure Monitor / Application Insights,可以从 Azure Portal 中查看性能指标、调用成功率、异常等,帮

以编程方式设置和运行 Azure Prompt Flow

https://www.liangyouze.com/2024/11/24/以编程方式设置和运行 Azure Prompt Flow/