大概有这样的需求

- 达到xxx条件。比如是到了某个时刻。机器人自动在群里通知,并@相关的人

- 比如在群里回复一个关键词、然后期望得到想要的信息,以达到解放双手的目的。这一块儿就需要自己对接钉钉API来实现了。比如这种问答式的

大概有这样的需求

合适以及为何使用最少使用(LFU)缓存与Golang中的实现

在过去的这些年,参与计算机科学和工程师的人们一直在努力优化各种性质。我们生活在一个资源有限的世界里,人们一直致力于优化成本和速度的方法。

在软件工程方面而言,我认为,最流行的改善性能的就是缓存了。在许多app都有缓存,依赖于软件方面的存储,缓存背后的想法非常简单。为了加载较快,存储数据经常被用到。

简介

小技巧

启动及关闭

教程篇

文本编辑

文本编辑的高效命令

other

得益于 vim 的指法,敲起代码来如行云流水。不管是不是写代码,学好vim 指法相当重要,当然最重要的还是为了效率,节省时间做更多其他的事。

1 | // NOT BAD |

反射来自元编程,指通过类型检查变量本身数据结构的方式,只有部分编程语言支持反射。反射是指一类应用,它们能够自描述和自控制。也就是说,这类应用通过采用某种机制来实现对自己行为的描述(self-representation)和监测(examination),并能根据自身行为的状态和结果,调整或修改应用所描述行为的状态和相关的语义。

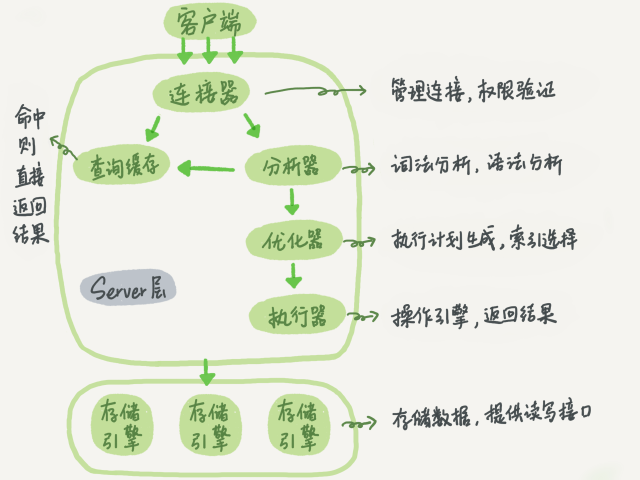

InnoDB的数据存储在表空间,表空间是由InnoDB管理的一个黑盒子,由一系列的数据文件组成。InnoDB采用MVCC来支持高并发

Server 层包括连接器、查询缓存、分析器、优化器、执行器等,涵盖 MySQL 的大多数核心服务功能,以及所有的内置函数(如日期、时间等),所有跨存储引擎的功能都在这一层实现,比如存储过程、触发器、视图等。

其实其中一点特性我理解起来就有点像java中的finally的用法

关于官方解释

1 | A defer statement defers the execution of a function until the surrounding function returns. |

这里提到了defer调用的参数会立即计算,但在周围函数返回之前不会执行函数调用。